Em dezembro último, o Fórum SBTVD (Sistema Brasileiro de Televisão Digital) anunciou o fim da Fase 2 de testes da chamada TV 3.0, realizada em 2021. Começa agora a Fase 3, em que as equipes do Fórum – somadas a técnicos das emissoras, fabricantes, desenvolvedores e universidades – definirão as tecnologias a serem adotadas no novo padrão de transmissões da TV aberta, que a partir de 2024 deve substituir o atual SBTVD.

Para quem não se lembra, o padrão utilizado atualmente no Brasil foi inaugurado oficialmente em 2006 e vem sendo implantado aos poucos. O SBTVD foi derivado do padrão japonês ISDB, tendo como base a TV de Alta Definição (HDTV). Foi adotado um longo cronograma de transição, o chamado switch-off, com as emissoras de cada região sendo obrigadas a trocar seus transmissores, substituindo o antigo padrão analógico.

Desta vez, acontecerá um processo semelhante, só que facilitado pelas experiências acumuladas nos últimos 15 anos. “Na época, não existia o Fórum”, diz o engenheiro Luiz Fausto de Souza Brito, que coordena os vários grupos técnicos encarregados dos testes para a TV 3.0. “Não havia uma entidade responsável, apenas um grupo na SET/ABERT (entidades que representam as emissoras), outro no Minicom (Ministério das Comunicações), uma série de discussões, e o processo foi sendo construído. A criação do Fórum foi muito boa porque tem a participação de todos os setores: radiodifusão, indústria de equipamentos, de software, academia, governo”.

Desta vez, acontecerá um processo semelhante, só que facilitado pelas experiências acumuladas nos últimos 15 anos. “Na época, não existia o Fórum”, diz o engenheiro Luiz Fausto de Souza Brito, que coordena os vários grupos técnicos encarregados dos testes para a TV 3.0. “Não havia uma entidade responsável, apenas um grupo na SET/ABERT (entidades que representam as emissoras), outro no Minicom (Ministério das Comunicações), uma série de discussões, e o processo foi sendo construído. A criação do Fórum foi muito boa porque tem a participação de todos os setores: radiodifusão, indústria de equipamentos, de software, academia, governo”.

TESTES DE CAMPO E DE LABORATÓRIO

Fausto comanda um total de 70 pessoas que representam sete instituições. Esse pessoal altamente técnico foi organizado em grupos que se dedicam a cada um dos aspectos da TV 3.0. Um exemplo é o que se chama tecnicamente de Camada Física e de Transporte, nome dado aos equipamentos e tecnologias que permitem a transmissão do sinal de áudio e vídeo sem fio em longas distâncias.

Os testes de laboratório são feitos na Universidade Mackenzie (SP), enquanto os testes de campo ficam a cargo da Universidade Federal Fluminense (UFF/RJ); os testes de codificação de vídeo cabem à Universidade de Brasilia, com uma equipe específica para cuidar da codificação de áudio, centralizada na USP.

Há ainda pessoal técnico responsável especificamente pela legendagem e linguagem de sinais (captions), trabalho concentrado na Universidade da Paraíba, enquanto dois outros grupos – na PUC-RJ e na Universidade de Juiz de Fora – cuidam das aplicações, ou seja, todo o conjunto de softwares e aplicativos que fará os sinais chegarem com qualidade às casas dos telespectadores.

Essa foi a estrutura utilizada durante a Fase 2, em que o Fórum definiu boa parte das tecnologias a ser utilizadas. Na Fase 1, a entidade havia recebido sugestões de diversos segmentos ligados à radiodifusão, inclusive de 21 organizações internacionais que têm interesse no padrão brasileiro. Os testes da Fase 2 serviram para avaliar cada uma delas e selecionar as mais viáveis.

SISTEMA HÍBRIDO: TV + INTERNET

É importante lembrar que a TV 3.0, por definição, representa uma ruptura com o padrão anterior. Pela primeira vez, teremos um sistema de transmissão híbrido de televisão e internet, combinando recursos das duas mídias, mas de uma forma transparente para o usuário.

“Ele não irá perceber se o sinal vem da emissora ou do aplicativo”, explica Fausto, nesta entrevista exclusiva. “E isso, na prática, não faz diferença, porque o importante é que o sinal chegue com boa qualidade de som e imagem, sem travamentos, não importando se a pessoa está assistindo pelo televisor ou por um dispositivo móvel”.

P – Quais foram os critérios do Fórum para escolher as tecnologias que servirão de base à TV 3.0?

R – Os testes foram realizados entre julho e novembro de 2021, com acompanhamento semanal de todas as equipes. Além dos componentes técnicos, foram considerados também aspectos de mercado e de royalties (propriedade intelectual). A TV 3.0 já vem sendo implantada em outros países, e é claro que nós procuramos aprender com essas experiências. Nossa prioridade é criar um padrão que seja aberto, gratuito e interoperável, ou seja, que todas as pessoas possam acessar, independente de qual receptor estiverem usando.

P – Como o Fórum administra eventuais disputas e conflitos comerciais entre os diversos setores envolvidos? O governo brasileiro tem de pagar alguma coisa?

R – Recebemos propostas do mundo inteiro e todas foram analisadas na Fase 2: ATSC (EUA), DVB (Europa), DT-Neo (China) etc. O novo padrão brasileiro não será baseado em nenhum outro, como foi o SBTVD, por exemplo, que teve por base o ISDB japonês. Será uma combinação de tecnologias que melhor se adaptem à realidade do nosso país. Empresas e entidades internacionais têm interesse em vender equipamentos para as emissoras brasileiras. Mas nós não entramos nessa briga comercial. Emissoras, fabricantes e desenvolvedores brasileiros têm liberdade para comprar de quem quiserem, mas nem o Fórum nem o governo brasileiro irão pagar nada.

P – Mas o uso dessas tecnologias exige pagamento de royalties…

R – Sim, são negociações diretas entre o fabricante de TVs, por exemplo, e o detentor daquela propriedade. Pode ser uma empresa como a Dolby, que detém os direitos do Dolby Atmos e Dolby Vision, ou um pool de patentes (como é o caso do padrão de codificação SL-HDR2). O que exigimos é o chamado “licenciamento FRAND”: fair, reasonable and non-discriminatory (“justo, razoável e não-discriminatório”). Se eu sou detentor de uma tecnologia, não posso cobrar preços diferentes de um fabricante que é meu amigo e de outro que não é. Isso é para evitar a criação de silos de mercado e condições desiguais de competição.

SINAL ENTRARÁ PELA ANTENA NA FORMA DE BITS

P – Falando especificamente sobre os testes, quais são as principais inovações técnicas que vocês testaram e aprovaram?

P – O primeiro componente é o que chamamos Camada Física, ou seja, as tecnologias usadas para transmitir o sinal sem fio. É o que determina como o sinal sai da antena de transmissão e é recuperado na recepção. Um processo chamado modulação e demodulação. Estamos falando de comunicação digital, então na verdade você transmite uma sequência de bits e consegue recuperá-la na casa do usuário. Só que as antenas não enviam e recebem bits, mas radiofrequências que precisam ser moduladas, modificando a amplitude, a frequência, a fase etc. Quanto mais eficiente essa tecnologia, vamos conseguir transmitir mais bits por segundo num mesmo canal. Quanto mais avançada a estrutura de camada física, mais robusta e eficiente a transmissão.

P – O sinal no caso é transmitido por ondas de rádio, como na TV atual, mas incorporando também sinais da internet? Como se faz isso?

R – Aí estamos falando da Camada de Transporte, que independe da Camada Física. No caso da internet, utiliza-se a codificação TCP/IP. Não importa se na sua casa você está usando uma rede Wi-Fi, 5G, 4G, Bluetooth… o receptor de TV terá um transporte por IP, baseado no padrão de compressão MPEG-DASH. A camada de transporte é a “cola” que compatibiliza as outras camadas. Ela sinaliza para o receptor o sinal que ele vai receber. Para ele interpretar isso, a próxima etapa é desmontar (demultiplexar) o sinal. Ali dentro tem áudio, vídeo, captions, aplicações e uma série de metadados que dizem ao receptor o que há naquele sinal. A camada de transporte organiza todos os componentes do sistema dentro de um único fluxo.

R – Aí estamos falando da Camada de Transporte, que independe da Camada Física. No caso da internet, utiliza-se a codificação TCP/IP. Não importa se na sua casa você está usando uma rede Wi-Fi, 5G, 4G, Bluetooth… o receptor de TV terá um transporte por IP, baseado no padrão de compressão MPEG-DASH. A camada de transporte é a “cola” que compatibiliza as outras camadas. Ela sinaliza para o receptor o sinal que ele vai receber. Para ele interpretar isso, a próxima etapa é desmontar (demultiplexar) o sinal. Ali dentro tem áudio, vídeo, captions, aplicações e uma série de metadados que dizem ao receptor o que há naquele sinal. A camada de transporte organiza todos os componentes do sistema dentro de um único fluxo.

P – Isso vale tanto para o sinal das emissoras quanto para o streaming da Netflix, por exemplo?

R – Estamos usando uma camada baseada em IP e DASH, a mesma que é usada nos serviços de streaming (OTT). É similar ao que se conhece por “streaming adaptativo”. Claro que, na transmissão pelo ar, não é adaptativo porque o canal tem capacidade fixa. Na internet, a capacidade ora aumenta ou diminui porque a conexão flutua. O fato de usar uma tecnologia similar facilita. Se quisermos combinar um sinal vindo pelo ar com outro vindo pela internet, estamos usando a mesma camada de transporte. Então, para o receptor é uma comutação muito simples, transparente. É como entre um servidor e outro, e você assistindo um streaming nem nota. Vai ser muito mais fluido, transparente, sem descontinuidade nem tela preta, com melhor integração entre broadcast x broadband.

O DESAFIO DE TRANSMITIR HDR PELO AR

P – Como a TV 3.0 irá lidar com os sinais HDR e suas variações, que são mais complexos que o sinal convencional?

R – Tivemos três tecnologias candidatas: Dolby Vision, HDR10+ e SL-HDR2 (antigo Advanced HDR by Technicolor). Foram todas aprovadas porque são interoperáveis. No HDR, existe uma camada que é o vídeo propriamente dito e outra que é de metadados estáticos. HDR permite que o vídeo tenha variações muitos grandes de brilho (luminância), de 0.0001 até 10.000 nits. Monitores têm capacidades diferentes de pico, dependendo do tipo de display, backlight etc. Não era um problema na época do SDR porque todos os displays atendiam aquele mínimo de 100 nits. Tinha um sinal de vídeo que excursionava de 0 a 100 nits e todos os sinais eram transmitidos dessa forma. Com HDR, entramos num novo mundo. Você tem uma faixa muito grande, maior que a dos TVs. Então, tem que ajustar o conteúdo para a capacidade do display. Para isso, precisa de metadados.

P – Para ter a TV 3.0, as pessoas terão que adquirir TVs com todos os tipos de HDR?

R – O fato da Norma suportar os três formatos permite mais flexibilidade para o mercado se posicionar e definir qual vai ser o formato dominante. Todos os TVs aceitam metadados estáticos, então existe interoperabilidade. Consigo transmitir um sinal que pode ser visto em qualquer monitor. Os monitores HDR que temos no mercado hoje variam entre 400 e 4.000 nits, aproximadamente. Se você tiver um sinal com pico de 10.000 nits e ajustar para o limite do monitor, vai perder todos os detalhes das cenas escuras, terá um vídeo lavado. Então, tem que fazer um meio termo para entregar o melhor vídeo que o seu monitor consegue reproduzir.

P – Na prática, hoje não existem conteúdos de 10.000 nits. Na TV 3.0, isso será possível?

R – Sim, mas é importante deixar claro que essa é uma opção da indústria e das emissoras. A Norma é flexível, não obriga a usar este ou aquele padrão. Você tem uma camada que é o vídeo HDR-PQ e uma camada de metadados estáticos, que diz: o pico deste filme é, digamos, 1.000 nits. O monitor vai ler essa informação, comparar com a sua própria capacidade e fazer o ajuste mais adequado. O padrão de metadados estáticos mais usado é o HDR-10: todos os TVs HDR hoje suportam. Em cima disso você pode adicionar metadados dinâmicos. Em vez de fazer um único ajuste para o filme todo, faz quadro a quadro e diz: neste quadro o brilho excursiona de tanto a tanto, e o TV pode ajustar cada quadro da imagem. Então, você só poderá ter metadados dinâmicos se a sua TV for compatível com o padrão usado na transmissão. A emissora vai ter que escolher um dos três (DV, HDR10+ ou SL-HDR2). Se o sinal não tiver nenhum dos três, a TV vai ignorar o dinâmico e usar metadados estáticos, ou seja, tratar aquele vídeo como HDR10. Mas sempre haverá um adicional de qualidade se estiver usando o dinâmico.

COMO SERÃO AS TRANSMISSÕES DE TV EM 4K E 8K

P – E como fica a questão da resolução na TV 3.0? Teremos 4K e 8K vindo pelo ar?

R – Decidimos adotar a tecnologia DRE (Dynamic Resolution Encoding), que chamamos single-layer, ou seja, um único fluxo de vídeo. Quando você assiste streaming, o fluxo da resolução é adaptativo, ou seja, se ajusta à velocidade entre o servidor de origem e o seu receptor. As pessoas às vezes confundem, achando que o sinal se ajusta à sua velocidade de conexão, mas pode haver um congestionamento na rede, e não na casa do usuário (a chamada “última milha”). Entre o servidor e o TV existe um caminho que pode ter limitação de capacidade. O tráfego pode variar e uma hora você tem tantos megabits por segundo, outra hora tem menos… O vídeo é codificado em diferentes qualidades e o sistema fica monitorando o buffer do receptor para ver se aumenta ou diminui a qualidade. O telespectador nem sempre nota essa comutação. Quando é muito drástica, consegue-se ver que o vídeo piorou de qualidade, mas se for sutil o usuário não percebe. Essa tecnologia foi desenvolvida para lidar com distribuição de conteúdos pela internet.

P – O novo padrão prevê algum tipo de controle para não deixar a resolução cair abaixo de determinado nível?

R – Veja, quando você recebe o sinal pela internet o vídeo não está sempre na mesma resolução. Pode ser 4K, 1080p, 720p… pode estar variando também a taxa de quadros (30, 60, 120Hz), e o TV faz sempre a comutação de acordo com sua capacidade. Se o vídeo tiver resolução maior que o display, faz downscaling; se tiver taxa de quadros menor, vai repetir quadros; se for maior, vai eliminar quadros. Isso tornou os TVs capazes de fazer comutações contínuas de resolução e taxa de quadros (frame-rate). Quando se aumenta a resolução é mais complexo, porque um vídeo fica gigantesco: 1080p ocupa 3 Gigabits por segundo! O que o sistema diz é “posso gastar mais bits aqui porque é uma parte mais visível”, e menos aqui porque as pessoas não vão prestar tanta atenção. Ele usa formas inteligentes de economizar bits minimizando a distorção e a percepção de perda de qualidade. Tem uma mágica para fazer o sinal caber num fluxo maior.

P – Pode explicar melhor essa mágica?

R – Vídeos diferentes têm diferentes complexidades. Há cenas com muitas formas, cores, detalhes, outras têm padrões mais uniformes; algumas são rápidas, outras são lentas. Tudo isso muda a complexidade do sinal. Se você disser ao codec que ele tem de codificar 5Mbps numa determinada resolução, o que ele vai fazer é que algumas cenas vão ficar muito boas e outras não. Depende da complexidade da cena. Pode parecer estranho, mas às vezes você reduz a resolução e melhora a qualidade do vídeo, já que há um limite de taxa. Não adianta eu pegar um vídeo 8K e codificar em 1Mbps, vai ficar um lixo. Se essa é a banda, provavelmente o vídeo vai ficar melhor usando resolução mais baixa.

P – O sistema consegue fazer isso em tempo real para não prejudicar a experiência do telespectador?

R – Sim, essa é a função do DRE: separar o vídeo em segmentos, o que já é normal em streaming. No DASH, trabalhamos em segmentos de 2 segundos. Ele pega cada segmento e analisa: dado que a taxa é tanto, qual é a melhor resolução e frame-rate que eu posso usar? Do lado do encoder, ele codifica a taxa de quadros em diferentes resoluções e faz uma pontuação de qualidade. Ex.: entrei com 4K60p no encoder; ele gera uma versão 4k60p e também uma 1080, 720p30… quantas versões o encoder quiser fazer, e dá uma nota a cada uma. A que tiver a melhor nota vai ser o vídeo que eu vou exibir. A intenção é sempre entregar a melhor resolução possível para aquela taxa, mas vai ficar comutando, não será sempre 4K ou sempre 1080. Cenas mais paradas provavelmente vão se beneficiar de mais resolução. Cenas mais rápidas terão melhor qualidade se você diminuir a resolução e aumentar a taxa de quadros. Seu monitor lida com isso de uma forma natural, pode ir ajustando num único fluxo. É um processo automático, sem intervenção humana.

P – O que tem sido publicado é que a TV 3.0 irá misturar os sinais de broadcast (emissoras) e broadband (internet). Mas hoje as emissoras já estão levando seus conteúdos para o streaming. O usuário será obrigado a escolher entre um e outro?

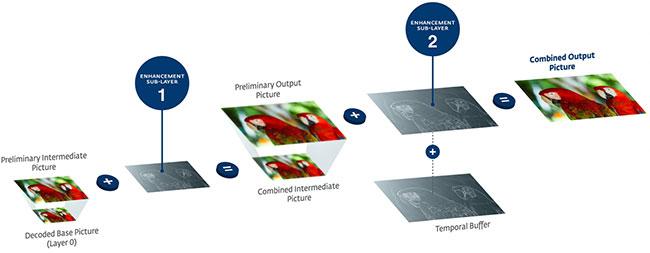

R – Não, ele nem precisará escolher. Existe uma tecnologia chamada LCEVC (Low Complexity Enhancement Video Coding), que chamamos “enriquecimento multicamada”. Cada canal de TV digital ocupa 6 Megahertz. Essa faixa pode ser dividida para combinar mais de um fluxo de vídeo. Ex.: um canal transmitindo 1080p e um segundo canal com camada de enriquecimento que transforma esse mesmo vídeo em 4K. Como são dois fluxos separados, posso ter um receptor mais simples que pega um único canal 1080p, e um TV mais avançado que vai receber os dois canais, demodular, combinar os dois fluxos e entregar 4K.

TRANSMISSÃO DE TV SERÁ PARECIDA COM O STREAMING

P – A opção seria usar o canal inteiro de 6MHz para transmitir um fluxo 100% 4K, certo?

R – Não, não cabe. O esquema acima é a única forma de entregar uma qualidade maior sem que todos os receptores precisem ter dois tuners. Um segundo uso é ter um vídeo em determinada qualidade pelo ar (ex: 1080p num canal de 6MHz) e um enriquecimento 4K (ou até 8K) sendo transmitido pela internet. Eu combino o que vem pelo ar e o que vem pela internet para entregar uma qualidade maior. Poderia entregar num único fluxo pela internet? Poderia, mas iria gastar mais banda. É melhor se eu puder reaproveitar o vídeo que já estou transmitindo pelo ar, usando menos bits por segundo, e combinar essa camada básica pelo ar com a camada de enriquecimento pela internet para gerar uma qualidade maior.

P – Parece complicado para o consumidor, mas como você já disse antes ele nem vai perceber essas combinações…

R – Essa é a ideia da TV 3.0: tornar a TV aberta mais parecida com o serviço de internet. Serve tanto para comutar conteúdo (ora pelo ar, ora internet) quanto para combinar conteúdos de qualidades diferentes, e inclusive de áudio. Ex.: o jogo pelo ar está sendo transmitido por um narrador e você quer a narração de outro que está num serviço premium. O telespectador vai poder combinar o áudio da internet com o vídeo da emissora. Todas essas combinações estão previstas na TV 3.0.

P – E como fica esse processo todo quando se pensa em receptores móveis? Cada vez mais as pessoas assistem TV pelo celular…

R – Da camada de transporte para frente, celular e TV são iguais. Onde tem alguma diferença é na camada física, como se modula e demodula o sinal. No padrão SBTVD tem a transmissão 1-seg: a emissora divide o canal de 6MHz em 13 segmentos e separa um deles para recepção móvel. Só que a qualidade de som e imagem é bem inferior à da televisão. Na TV 3.0 será diferente: um único sinal ocupando o canal de 6MHz que possa ser recebido com a mesma qualidade tanto numa recepção fixa (indoor) quanto na móvel (outdoor), inclusive quando a pessoa estiver em trânsito.

P – Que impacto a TV 3.0 terá para o segmento de TV paga, que está sofrendo a concorrência do streaming?

R – Bem, o Fórum não se envolve em questões relacionadas à TV paga, porque esse é um serviço de telecom, não regulamentado. Lidamos com as normas de TV aberta. Essas tecnologias descritas acima não se aplicam diretamente à TV paga, mas como aconteceu na implantação do SBTVD as operadoras acabam utilizando recursos da TV aberta para aprimorar seus serviços. A partir do momento em que existe um canal capaz de distribuir mais qualidade pela TV aberta (seja 4K, 8K, HDR, áudio imersivo…), as emissoras passam a produzir nesses formatos, e essas produções ficam disponíveis para distribuição na TV paga. Eventualmente usarão outras tecnologias de modulação e demodulação, mas o fato da gente habilitar a TV aberta a produzir significa que haverá conteúdos em novos formatos.

P – Quais serão os próximos passos no cronograma da TV 3.0?

R – Na Fase 2, todas as decisões tomadas por consenso entre as equipes. Foram recomendadas tecnologias para cada um dos grupos, em alguns casos há mais de uma, visando a Fase 3. Na Camada Física, por exemplo, serão necessários mais testes. Em outras, já está decidido. Agora, vamos para a Fase 3 e em 2023 deveremos apresentar tudo ao Ministério das Comunicações, a quem caberá a decisão final. Aliás, todos os relatórios estão no site do Fórum para quem quiser consultar. Achamos importante que tudo seja público. Os testes tiveram financiamento público, então essa transparência é uma prestação de contas. Agora, é preciso entender que esse processo é mesmo demorado, pois radiodifusão no Brasil é um setor regulado. Em telecom, é serviço privado: a operadora tem uma licença, mas esta não vincula qual tecnologia deve ser usada. Em radiodifusão, é necessário todo esse arcabouço de normas técnicas que devem ser seguidas por todas as empresas, não só as emissoras. E são normas que têm um ciclo mais longo. Você não troca de TV com tanta frequência quanto celular.